Что такое биг-дата? простой ответ для каждого

Содержание:

- Описание технологии Big Data

- История возникновения

- Примеры использования Big Data

- IT-консультанты

- Сдерживающий фактор

- Примеры использования Big Data

- Проблемы Big Data

- Будущее ЦОД — за модульными решениями

- Что мешает дальнейшему развитию

- Большие данные: с чего начать

- 2013: Хартия открытых данных G8

- General Electric минимизация убытков от простоев благодаря big data

- Как используется Биг-Дата?

- Какие функции есть у платформ анализа больших данных

- Советы

- Вывод

Описание технологии Big Data

Под термином Big Data подразумеваются как сами данные, так и их анализ с помощью аналитических систем.

Рассмотрим, какими признаками обладают большие данные <4>:

- Volume: действительно большие (хотя размер зависит от доступных ресурсов для их обработки);

- Variety: слабо структурированные и разнородные;

- Velocity: обрабатывать надо очень быстро (причем и результаты часто нужны оперативно, если речь об онлайновых сервисах).

<4> Как Big Data работает в России (http://www.popmech.ru/technologies/15670-kak-big-data-rabotaet-v-rossii/).

В сущности, понятие больших данных подразумевает работу с информацией огромного объема и разнообразного состава, весьма часто обновляемой и находящейся в разных источниках в целях увеличения эффективности работы, создания новых продуктов и повышения конкурентоспособности. Большие данные — это технологии, которые позволяют извлекать смысл из данных.

Большие данные предназначены для обработки более значительных объемов информации, чем бизнес-аналитика, и это, конечно, соответствует традиционному определению больших данных.

Большие данные предназначены для обработки более быстро получаемых и меняющихся сведений, что означает глубокое исследование и интерактивность. В некоторых случаях результаты формируются быстрее, чем загружается веб-страница.

Большие данные предназначены для обработки неструктурированных данных, способы использования которых мы только начинаем изучать после того, как смогли наладить их сбор и хранение, и нам требуются алгоритмы и возможность диалога для облегчения поиска тенденций, содержащихся внутри этих массивов.

Работа с большими данными не похожа на обычный процесс бизнес-аналитики, где простое сложение известных значений приносит результат: например, итог сложения данных об оплаченных счетах становится объемом продаж за год. При работе с большими данными результат получается в процессе их очистки путем последовательного моделирования: сначала выдвигается гипотеза, строится статистическая, визуальная или семантическая модель, на ее основании проверяется верность выдвинутой гипотезы и затем выдвигается следующая. Этот процесс требует от исследователя либо интерпретации визуальных значений или составления интерактивных запросов на основе знаний, либо разработки адаптивных алгоритмов машинного обучения, способных получить искомый результат. Причем время жизни такого алгоритма может быть довольно коротким. Представим на рис. 1 процесс сбора, хранения обработки информации в соответствии с технологией Big Data.

История возникновения

Название Big Data появилось в 2000-х, но концепция обработки большого количества данных возникла гораздо раньше. Менялся только объем и масштаб. В 1960-х годах начали создаваться первые хранилища больших данных, а сорок лет спустя компании увидели, сколько наборов данных можно собрать с помощью онлайн-сервисов, сайтов, приложений и любых продуктов, с которыми взаимодействуют клиенты. Именно тогда начали набирать популярность первые сервисы Big Data (Hadoop, NoSQL и т.д.). Наличие таких инструментов стало необходимо, поскольку они упрощают и удешевляют хранение и анализ.

Большие данные часто характеризуются тремя факторами: большим объемом, большим разнообразием типов данных, хранящихся в системах, и скоростью, с которой данные генерируются, собираются и обрабатываются. Эти характеристики были впервые выявлены Дугом Лэйни, аналитиком в Meta Group Inc., в 2001 году. Компания Gartner популяризировала их после того, как в 2005 году приобрела Meta Group. Постепенно к этим описаниям больших данных стали добавляться и другие критерии (достоверность, ценность и так далее).

В 2008 году с Клиффорд Лина в спецвыпуске журнала Nature эксперт назвал взрывной рост потоков информации big data. В него он отнес любые массивы неоднородных данных свыше 150 Гб в сутки. С тех пор термин «большие данные» прочно укрепился.

Примеры использования Big Data

- создания контента для разной целевой аудитории;

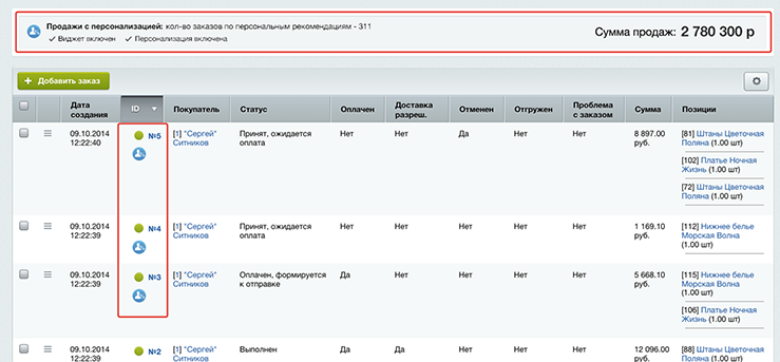

- разработки персональных рекомендаций;

- измерения эффективности контента.

Например, музыкальный сервис Spotify использует big data для сбора данных от миллионов пользователей по всему миру, а затем использует проанализированные данные для предоставления музыкальных рекомендаций отдельным пользователям.

Рекламодатели – одни из крупнейших игроков в сфере больших данных. Facebook, Google, Яндекс или любой другой онлайн-гигант – все они отслеживают поведение пользователей. В результате они предоставляют рекламодателям большой объем данных для точной настройки кампаний. Возьмем, к примеру, Facebook. Здесь можно выбрать аудиторию на основе покупательского намерения, посещений веб-сайтов, интересов, должности, демографии и т.д. Все эти данные собираются алгоритмами Facebook с использованием методов анализа big data.

Логистика

Логистические компании уже довольно давно используют аналитику для отслеживания заказов и составления отчетов. Благодаря большим данным можно отслеживать состояние товаров в пути и оценивать потери. В режиме реального времени собираются данные о дорожном движении, погодных условиях и определяются маршруты для транспортировки грузов. Это помогает логистическим компаниям снизить риски, повысить скорость и надежность доставки.

Медицина

Большие данные в здравоохранении используются для улучшения качества жизни, лечения болезней, сокращения непроизводительных затрат, прогнозирования эпидемий. Используя big data, больницы могут повысить уровень обслуживания пациентов.

Розничная и оптовая торговля

Взаимодействие с поставщиками, покупателями, анализ запасов на складе, прогнозирование продаж – это лишь часть функций, с которыми помогает справляться Big Data.

Государственные структуры

В качестве примеров: учет налоговых поступлений, сбор и анализ данных, собранных в интернете (новости, социальные сети, форумы и т.д.) для противодействия экстремизму и организованной преступности, оптимизация транспортной сети, выявление районов избыточной концентрации работающего, проживающего или незанятого населения, изучение предпосылок к развитию территорий и так далее.

Банковская сфера

Сбор и анализ информации помогает банкам бороться с мошенничеством, эффективно работать с клиентами (сегментировать, проводить оценку кредитоспособности клиентов, предлагать новые продукты), управлять работой отделений (например, прогнозировать очереди, нагрузку специалистов и так далее).

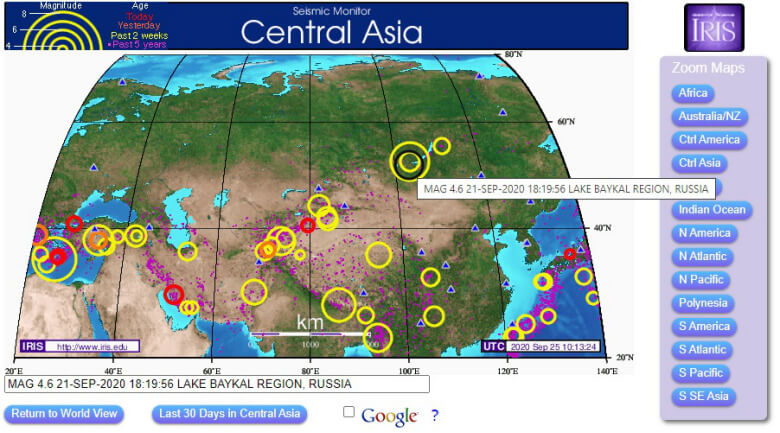

Предупреждение природных и техногенных катастроф

Множество машин ежедневно отслеживают сейсмическую активность в режиме реального времени. Это позволяет ученым спрогнозировать землетрясение. Даже обычным пользователям интернета также доступны эти инструменты наблюдений: есть различные, на которых представлены интерактивные карты.

Для сохранения безопасности на предприятиях также внедряются технологии, позволяющие обнаруживать и прогнозировать риски и предотвращать несчастные случаи.

IT-консультанты

Системные интеграторы разворачивают систему анализа больших данных на стороне клиента. Они выступают посредниками между технологиями и бизнесом. Это вариант для тех, кому не подходят готовые решения и облачные вычисления. «Преимущество интегратора в том, что он может комбинировать продукты разных вендоров, дополняющие друг друга», — говорил директор IBS по технологиям Сергей Кузнецов в интервью изданию Computeworld.«Форс»Направлением big data компания занялась в 2013 году. Они разрабатывают и развертывают аналитические системы для телекома, ритейла, банковского сектора, здравоохранения, госорганов и муниципальных служб. Кроме того, «Форс» предлагает готовый софт для анализа аудитории с помощью данных из соцсетей (ForSMedia) и формирования досье контрагента. Компания является официальным дистрибутором и платиновым партнером корпорации Oracle.«Крок»Интегратор плотно сотрудничает с EMC, HP, Oracle и Microsoft, Intel — с их решениями работает центр компетенций «Крок». Проекты в сфере больших данных компания начала реализовывать с 2013 года. Специалисты «Крок» строили модель по уменьшению оттока абонентов для крупного телеком-оператора, прогнозировали пассажиропотоки для «Центральной пригородной пассажирской компании», а сейчас реализуют проект в некой крупной страховой компании. В 2014 году объем направления big data достиг 1% в выручке «Крок».

Сдерживающий фактор

Ряд преград затрудняют использование данных, полученных от других пользователей, не нарушив их приватность, — умные устройства сильно связаны с частной жизнью своих владельцев. Кроме того, необходимо тщательно продумать вопрос безопасности. Использование умного обогревателя не должно привести к пожару, а плита не должна допустить утечки газа.

Из этого вытекает еще одна проблема — на кого ложится юридическая ответственность в несчастных случаях, связанных с использованием IoT? Неопределенность в отношении этих вопросов препятствует ведению бизнеса в области интернета вещей и, соответственно, внедрению промышленных решений Big Data.

Примеры использования Big Data

Активное внедрение технологий Big Data на рынок и в современную жизнь началось как раз после того, как ими стали пользоваться всемирно известные компании, имеющие клиентов практически в каждой точке земного шара.

Это такие социальные гиганты, как Facebook и Google, IBM., а также финансовые структуры вроде Master Card, VISA и Bank of America.

К примеру, IBM применяет методы больших данных к проводимым денежным транзакциям. С их помощью было выявлено на 15% больше мошеннических транзакций, что позволило увеличить сумму защищенных средств на 60%. Также были решены проблемы с ложными срабатываниями системы – их число сократилось более, чем наполовину.

Компания VISA аналогично использовала Big Data, отслеживая мошеннические попытки произвести ту или иную операцию. Благодаря этому ежегодно они спасают от утечки более 2 млрд долларов США.

Министерство труда Германии сумело сократить расходы на 10 млрд евро, внедрив систему больших данных в работу по выдаче пособий по безработице. При этом было выявлено, что пятая часть граждан данные пособия получает безосновательно.

Big Data не обошли стороной и игровую индустрию. Так, разработчики World of Tanks провели исследование информации обо всех игроках и сравнили имеющиеся показатели их активности. Это помогло спрогнозировать возможный будущий отток игроков – опираясь на сделанные предположения, представители организации смогли более эффективно взаимодействовать с пользователями.

К числу известных организаций, использующих большие данные, можно также отнести HSBC, Nasdaq, Coca-Cola, Starbucks и AT&T.

Проблемы Big Data

Самой большой проблемой больших данных являются затраты на их обработку. Сюда можно включить как дорогостоящее оборудование, так и расходы на заработную плату квалифицированным специалистам, способным обслуживать огромные массивы информации. Очевидно, что оборудование придется регулярно обновлять, чтобы оно не теряло минимальной работоспособности при увеличении объема данных.

Вторая проблема опять же связана с большим количеством информации, которую необходимо обрабатывать. Если, например, исследование дает не 2-3, а многочисленное количество результатов, очень сложно остаться объективным и выделить из общего потока данных только те, которые окажут реальное влияние на состояние какого-либо явления.

Проблема конфиденциальности Big Data. В связи с тем, что большинство сервисов по обслуживанию клиентов переходят на онлайн-использование данных, очень легко стать очередной мишенью для киберпреступников. Даже простое хранение личной информации без совершения каких-либо интернет-транзакций может быть чревато нежелательными для клиентов облачных хранилищ последствиями.

Проблема потери информации

Меры предосторожности требуют не ограничиваться простым однократным резервированием данных, а делать хотя бы 2-3 резервных копии хранилища. Однако с увеличением объема растут сложности с резервированием – и IT-специалисты пытаются найти оптимальное решение данной проблемы

Будущее ЦОД — за модульными решениями

Компаниям, которые работают с большими данными, необходимы производительные и гибкие ЦОД. Главные требования, предъявляемые к ним, — быстрое развертывание приложений, простое масштабирование без перерывов в работе, высокая энергоэффективность и рентабельность.

Поставленным задачам отвечают модульные ЦОД. В них основные узлы (система питания, охлаждения и управления энергопотреблением) разбиты на отдельные компоненты. Каждый участок проектируется в соответствии с единым стандартом, что позволяет обеспечить безотказную, независимую работу дата-центра.

Преимущества модульных ЦОД неоспоримы:

- Высокий уровень стандартизации делает возможным серийное производство, а это означает сокращение затрат и сроков изготовления, повышение качества и упрощение ремонта.

- Быстрый монтаж — в отличие от традиционного ЦОД, который строится от полугода до года, для развертывания модульного центра требуется от нескольких недель до нескольких месяцев.

- Масштабируемость и минимальные затраты на старте: интеграция дополнительных узлов производится по необходимости (с ростом объема данных).

- Сокращение среднего времени восстановления после отказа — за счет модульности и разъемных соединений любые ремонтные работы выполняются быстро.

Кроме того, модульные ЦОД отличаются высокой стабильностью — стандартизованные компоненты идеально взаимодействуют друг с другом.

Модульный ЦОД — это система, позволяющая быстро наращивать мощности по мере расширения бизнеса

В связи с распространением периферийных вычислений не менее востребованными стали контейнерные ЦОД «все в одном» с гибкими системами питания и охлаждения. Они являются буфером для кэширования и накопления данных между пользователями и крупным ЦОД. Их главное преимущество — быстрое построение, мобильность и масштабирование для любых сфер применения и решаемых задач.

Сегодня технология контейнерных центров обработки данных стала доступна бизнесу. Теперь ЦОД можно легко перевозить автомобильным или железнодорожным транспортом и размещать рядом с уже существующими мощностями, используя общий резервный генератор.

ЦОД больше не здание, у него появились колеса

Что мешает дальнейшему развитию

Технические проблемы, связанные с использованием решений Big Data, в течение последних лет удалось полностью устранить. Задачи, для решения которых недостаточно текущего набора технологий, встречаются крайне редко. Тем не менее, есть несколько факторов, замедляющих развитие big data.

Часто бизнес-процессы в компании недостаточно отлажены для применения новых технологий. Разные отделы компаний создают аналитические хранилища для своих нужд, данные в этих хранилищах оказываются рассогласованными и в результате, когда появляется необходимость решать более масштабные аналитические задачи, интеграция данных из разных источников оказывается сильно затруднена — требуется переход на общий стек технологий и кропотливая совместная работа аналитиков. Таких ситуаций можно избежать, если изначально ответственно подходить к хранению данных — стремиться к централизации, так называемой «единой версии правды».

Часто бизнес-процессы в компании недостаточно отлажены для применения новых технологий. Разные отделы компаний создают аналитические хранилища для своих нужд, данные в этих хранилищах оказываются рассогласованными и в результате, когда появляется необходимость решать более масштабные аналитические задачи, интеграция данных из разных источников оказывается сильно затруднена — требуется переход на общий стек технологий и кропотливая совместная работа аналитиков. Таких ситуаций можно избежать, если изначально ответственно подходить к хранению данных — стремиться к централизации, так называемой «единой версии правды».

Психологической преградой к внедрению Big Data до сих пор является мнимая дороговизна таких решений. При словах большие данные в голове возникает картинка дата-центра со стройными рядами серверов астрономической стоимости. На самом деле, сейчас существует большое количество платформ, предоставляющих виртуальные вычислительные ресурсы. Самые масштабные из них — такие как Amazon Web Services и Microsoft Azure — берут на себя практически все управление кластерами клиентов.

С точки зрения разработки ПО для Big Data ситуация также очень изменилась за последние три года. Многие open source проекты перешли из стадии тестирования в стабильные релизные версии, технологии виртуализации и контейнеризации позволяют разворачивать приложения любой сложности на кластерах любых конфигураций. На рынке появляется все больше специалистов, готовых работать с этими технологиями.

Большие данные: с чего начать

Зная, как в общем делится работа между специалистами больших данных, ответить на главный вопрос новичка в мире Big Data «с чего начать», становится гораздо проще. Прежде, чем погружаться в изучение множества мануалов по Apache Hadoop и алгоритмам Machine Learning, необходимо понять, что вас больше привлекает:

- прикладное программирование;

- администрирование;

- проектирование архитектуры информационных потоков и сопровождение;

- анализ данных;

- создание математических моделей и алгоритмов обработки информации.

Кроме того, отметим, что, помимо линейных специалистов (программистов, администраторов, инженеров, архитекторов), знания в области больших данных также необходимы руководителям, чтобы видеть возможности цифровизации своего бизнеса и потенциальную выгоду от его цифровой трансформации. При этом менеджеру совсем не обязательно знать во всех деталях, как, например, работает Apache Kafka. Однако, чтобы не быть «чайником», руководителю крайне полезно ориентироваться в отраслевых сценариях применения средств Big Data (use-cases), понимать способы монетизации больших данных и специфику корпоративной цифровизации, чтобы эффективно расходовать временные, трудовые и материальные ресурсы, а также не ждать от технологий больше, чем они могут дать. Обо всем этом и не только мы рассказываем на обучающем курсе «Аналитика Big Data для менеджеров».

В качестве дополнительной мотивации изучения Big Data, отметим, что профессионалы в этой области больше всех зарабатывают среди ИТ-специалистов. Например, в 2019 году, согласно ежегодному исследованию Stack OverFlow, годовая зарплата аналитиков, инженеров и исследователей данных в США равнялась 60-70 тысяч долларов, т.е. около 350 тысяч рублей в месяц. При этом, поскольку цифровизация стремительно проникает во все сферы деятельности, от промышленности до образования, спрос на специалистов по данным все время растет по всему миру, в т.ч. и в России. Таким образом, большие данные – это очень перспективная и финансово выгодная область ИТ.

Зарплаты ИТ-специалистов в 2019 году по данным Stack OverFlow

Что необходимо знать и уметь аналитику, исследователю, инженеру и администратору больших данных, мы рассмотрим в следующих статьях. Проверить свое знание основ Big Data и Data Science вы можете, пройдя открытый бесплатный интерактивный тест прямо у нас на сайте ответив на 10 простых вопросов по основам больших данных. А освоить практику работы с прикладными инструментами Big Data, Machine Learning и Internet of Things, вам помогут наши курсы обучения и повышения квалификации ИТ-специалистов в лицензированном учебном центре для руководителей, аналитиков, архитекторов, инженеров и исследователей Big Data в Москве.

Смотреть расписание

Записаться на курс

2013: Хартия открытых данных G8

Согласно определению Википедии, «открытые данные (англ. open data) — концепция, отражающая идею о том, что определённые данные должны быть свободно доступны для машиночитаемого использования и дальнейшей републикации без ограничений авторского права, патентов и других механизмов контроля». Хотя в этой формулировке не говорится о статусе владельцев ОД, но сегодня эта концепция ассоциируется в первую очередь с определенными обязательствами со стороны именно государства, в том смысле, что поддержка ОД является обязательным для правительственных структур, а коммерческие предприятия могут следовать ей на добровольной основе. То есть мы имеем дело с ситуацией, когда именно государство является своеобразным локомотивом продвижения идей ОД, подавая пример коммерческому рынку. Такая роль государства определяет тем, что именно оно аккумулирует огромные объемы разного рода данных, которые являются общественным достоянием.

Именно такое понимание роли государства было зафиксировано в Хартии открытых данных G8, которую Россия вместе с другими странами Большой восьмерки подписала в 2013 г. В этом документе, в частности, зафиксированы восемь базовых принципов ОД: полнота, первичность, своевременность, доступность, пригодность к машинной обработке, отсутствие дискриминации в доступе, отсутствие закрытых проприетарных форматов и лицензионная чистота.

Реализация положений Хартии подразумевает обязательства правительств по создания пространства открытых государственных данных (ОГД), которое должно стать не только средством расширения сферы применений ИТ и поддержки ИТ-бизнеса (в том числе на уровне стартапов), но и фактором общего развития социальной сферы и демократических моделей управления страной. С формальной точки зрения ОГД предназначены в первую очередь для разработчиков ИТ-систем, предпринимателей и разного рода исследователей, а уже через них — для более широкой общественности. Одна из ключевых идей концепции: разделение сфер деятельности органов власти и бизнес, когда первые берут на себя задачи предоставления ОГД, а вторые — создания собственно разного рода информационных сервисов и продуктов, имея в виду, конечно, получение определенных коммерческих результатов. При этом государство экономит бюджетные средства на разработку собственных сервисов и обеспечивает высокий уровень качества предоставления услуг конечным пользователям за счет рыночной конкуренции.

General Electric минимизация убытков от простоев благодаря big data

Компания известна как крупный разработчик и поставщик оборудования для предприятий. С её заводов выходят локомотивы, энергетические установки, двигатели, газовые турбины, медицинская и осветительная техника. Объёмы очень велики, и остановка завода может привести к огромным убыткам. Чтобы предупредить простои, в General Electric используют специальные датчики, которые собирают данные о состоянии рабочего оборудования: его температуре, уровне топлива, общей производительности и анализируют другие параметры. Например, каждая из 22 000 заводских ветряных турбин постоянно отправляет информацию в облако. Анализируя её, можно вычислить оптимальный угол наклона лопастей, при котором турбина выдаёт максимальное количество энергии. Интеллектуальные алгоритмы обучения позволяют турбинам «брать пример» с соседних, если они действуют более эффективно. Своими наработками General Electric делится с клиентами и тем самым помогает им серьёзно экономить только за счёт сокращения простоев оборудования.

Как используется Биг-Дата?

Этот постоянно увеличивающийся поток информации о данных датчиков, текстовых, голосовых, фото- и видеоданных означает, что теперь мы можем использовать данные теми способами, которые невозможно было представить еще несколько лет назад. Это привносит революционные изменения в мир бизнеса едва ли не в каждой отрасли. Сегодня компании могут с невероятной точностью предсказать, какие конкретные категории клиентов захотят сделать приобретение, и когда. Биг Дата также помогает компаниям выполнять свою деятельность намного эффективнее.

Даже вне сферы бизнеса проекты, связанные с Big-Data, уже помогают изменить наш мир различными путями:

- Улучшая здравоохранение — медицина, управляемая данными, способна анализировать огромное количество медицинской информации и изображений для моделей, которые могут помочь обнаружить заболевание на ранней стадии и разработать новые лекарства.

- Прогнозируя и реагируя на природные и техногенные катастрофы. Данные датчиков можно проанализировать, чтобы предсказать, где могут произойти землетрясения, а модели поведения человека дают подсказки, которые помогают организациям оказывать помощь выжившим. Технология Биг Даты также используется для отслеживания и защиты потока беженцев из зон военных действий по всему миру.

- Предотвращая преступность. Полицейские силы все чаще используют стратегии, основанные на данных, которые включают их собственную разведывательную информацию и информацию из открытого доступа для более эффективного использования ресурсов и принятия сдерживающих мер там, где это необходимо.

Лучшие книги о технологии Big-Data

Какие функции есть у платформ анализа больших данных

Каждый data science-проект проходит жизненный цикл, состоящий из трех этапов:

- Сбор данных и исследование.

- Экспериментирование и разработка модели.

- Развертывание и интеграция.

На каждом этапе специфические задачи, которые помогает выполнять платформа. И есть более общие задачи, включающие управление данными, управление процессами обработки и масштабирования.

Для решения всех этих задач платформы обработки данных предлагают такой технический функционал: прием, подготовка и исследование данных, генерация признаков, создание, обучение, тестирование и деплой моделей, мониторинг и обслуживание системы.

Также платформа должна обеспечивать безопасность данных и их хранение, каталогизацию источников, предоставлять инструменты для визуализации и формирования отчетов. Облачные платформы дополнительно дают большой объем хранилища и вычислительных мощностей.

Все перечисленные функции платформ нужны, чтобы:

- ускорять работу специалистов;

- публиковать модели и интегрировать их в бизнес-процессы;

- делиться понятными, читаемыми результатами анализа с сотрудниками всех подразделений;

- сохранять прошлые наработки, включая метаданные, код, датасеты и обсуждения, и использовать их в новых проектах;

- создать общую базу знаний и собирать лучшие практики, на которых будут учиться новые сотрудники;

- безопасно внедрять новые инструменты, не ломая текущие процессы и не вмешиваясь в работу коллег;

- масштабировать вычислительные мощности;

- контролировать доступы к каждому проекту, чтобы его видели только определенные сотрудники.

Советы

Соблюдайте логику хранения данных

Нельзя взять способ, которым вы хранили данные в Hadoop, и перенести его, например, в Vertica. Каждая система адаптирована под определенное хранение данных. Это могут быть широкие таблицы, звезда-снежинка, Data Vault, Anchor, третья нормальная форма или гибридная модель. Поэтому адаптируйте архитектуру под продукты и задачи и смотрите, что лучше подходит.

Поделюсь моими историями успеха. Для Oracle и PostgreSQL лучше всего подходит третья нормальная форма, для ClickHouse — широкие таблицы. Vertica и Exasol очень хорошо работают с Data Vault. Ходят слухи, что Vertica круто работает с Anchor. Но мы столкнулись с тем, что с Anchor у каждой сущности появляется еще один интовый ключ. На ClickStream было много значений, и Anchor сильно увеличил объем хранимых данных. Пришлось вместо Anchor воспользоваться Data Vault, который позволяет сократить потребление данных. В Hadoop и Teradata хорошо работали вещи, близкие к третьей нормальной форме.

Выберите Spare Parts: шину данных, UI и ETL Manager

История про UI. Коллеги построили хранилище данных и выбрали UI в виде табло. Все были довольны, пока в компанию не пришел новый CEO. Он сказал: «Ваше табло мне не нравится, я привык к Power BI». Поскольку ребята хорошо построили систему, то переключение с табло на Power BI произошло достаточно быстро. Хорошее хранилище должно позволять подключить любой интерфейс, который является более или менее стандартным. Если аналитик считает, что ему удобно пользоваться табло, значит, нужно подключить табло. Если ему нравится Power BI, значит, нужно подключить его. Для этого есть стандартные протоколы, например, JDBC, есть система, которая поддерживает большинство стандартных UI

Обращайте на это внимание, но это не краеугольный камень. Скорее смотрите, чтобы можно было переключиться.

ETL-менеджер может развиваться динамически. Большинство из нас начинало свой ETL как набор задач в cron. Потом это становится трудно мониторить, и вы переходите на Airflow, Luigi, оркестратор Teradata, на что-то другое. Шина данных позволяет стандартизированно загружать данные в хранилище. Вещь важная, поскольку если вы не заложите ее в начале проектирования системы, то однажды поймете, что новых данных все больше и вам нужен какой-то стандарт для единого протокола загрузки в хранилище. Тогда окажется, что в ядре продукта есть логи, которые никто не хочет переделывать. Вам постоянно придется поддерживать это легаси, которое будет тянуться и тянуться, что весьма неприятно. Лучше ее проектировать сразу, хотя шину данных всегда можно поменять. А поменять хранилище тяжело и дорого.

Не бойтесь совмещать технологии

Вы можете использовать для хранения неструктурированных данных тот же Hadoop или S3 и загружать свои данные в другую базу данных. Если у вас есть специфические интерфейсы, например, для OLAP, то можно использовать дополнительные системы. Есть система Apache Kylin, которая работает с HBase в Hadoop и позволяет вам строить OLAP-кубики для стандартных OLAP-интерфейсов. Выбирайте и комбинируйте.

Есть популярный паттерн, когда на стандартную систему вроде Exasol и Vertica накладывается классическая SMP-система OLTP, в которую складываются подсчитанные данные, а далее из этой системы выдаются ответы. Например, если у вас есть личный кабинет клиента, то под него больше подойдет OLTP-система, в которой он будет смотреть отчеты. Сложные системы тяжелы в поддержке, но это компенсируется их плюсами. Нет системы, идеально решающей все задачи. Если у вас есть несколько популярных задач, будьте готовы, что под них нужно адаптировать разные системы.

Вывод

Если у вас нет DWH, то простой MVP можно накликать в облаке. Вы выбираете продукт, который поддерживается managed-сервисом, тот же Hadoop, и у вас уже есть какое-то хранилище. Попробуйте, и вы поймете, что это лучше, чем без хранилища.

Если вас не устраивает ваше DWH, попробуйте посмотреть на технологии вокруг. Для нас это был стресс. Я помню, каким для меня было вызовом, когда мне сказали: «Твой бесплатный Hadoop работает плохо, давайте посмотрим, какие есть платные хорошие решения». Я в ответ: «Что? Мой Hadoop? Да я сейчас напишу на Spark, всё будет работать очень быстро». Но я благодарен своим руководителям за то, что они предложили погонять PoC, и я понял, что коробочные решения могут делать гораздо быстрее и надежнее, чем Hadoop, который нужно настраивать несколько месяцев под одну задачу. Смотрите вокруг, ищите что-то хорошее, читайте Хабр и Medium. Иногда даже специфические продукты взлетают.