Знакомство с big data: полезная информация для чайников

Содержание:

- Что должен знать Data Engineer

- Data Mining — как собирается и обрабатывается Биг Дата

- Это искусственный интеллект?

- Монетизация процессов: оптимизация текущей деятельности

- Проблемы с Big-Data

- Карта пешеходных маршрутов

- Rolls-Royce: оптимизация проектирования и производства двигателей

- Что такое большие данные

- Немного про Cloud-Native подход в Data Science

- Использование Биг Дата — это законно?

- Актуальность и перспективы

- Язык данных — для решения проблем мирового масштаба

- История возникновения

- Лучшие книги по Big Data

- Рынок технологий больших данных в России и мире

- Определение

- Резюме

- Что такое «большие данные»

- Готовые сервисы на основе big data

- Какие тренды обсуждает сообщество

- О методах работы

- Решения на основе Big data: «Сбербанк», «Билайн» и другие компании

- Эволюция профессии: от 1960-х годов до наших дней

- Вывод

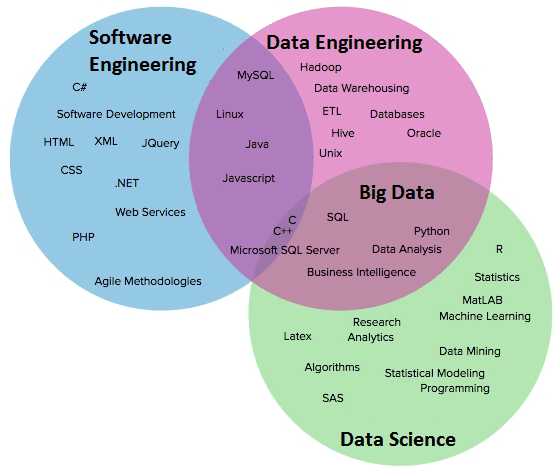

Что должен знать Data Engineer

-

Структуры и алгоритмы данных;

-

Особенности хранения информации в SQL и NoSQL базах данных. Наиболее распространённые: MySQL, PostgreSQL, MongoDB, Oracle, HP Vertica, Amazon Redshift;

-

ETL-системы (BM WebSphere DataStage; Informatica PowerCenter; Oracle Data Integrator; SAP Data Services; SAS Data Integration Server);

-

Облачные сервисы для больших данных Amazon Web Services, Google Cloud Platform, Microsoft Azure;

-

Кластеры больших данных на базе Apache и SQL-движки для анализа данных;

-

Желательно знать языки программирования (Python, Scala, Java).

Стек умений и навыков инженера больших данных частично пересекается с дата-сайентистом, но в проектах они, скорее, дополняют друг друга.

Data Engineer сильнее в программировании, чем дата-сайентист. А тот, в свою очередь, сильнее в статистике. Сайентист способен разработать модель-прототип обработки данных, а инженер — качественно воплотить её в реальность и превратить код в продукт, который затем будет решать конкретные задачи.

Инженеру не нужны знания в Business Intelligence, а вот опыт разработки программного обеспечения и администрирования кластеров придётся как раз кстати.

Но, несмотря на то что Data Engineer и Data Scientist должны работать в команде, у них бывают конфликты. Ведь сайентист — это по сути потребитель данных, которые предоставляет инженер. И грамотно налаженная коммуникация между ними — залог успешности проекта в целом.

Плюсы и минусы профессии инженера больших данных

Плюсы:

-

Отрасль в целом и специальность в частности ещё очень молоды. Особенно в России и странах СНГ. Востребованность специалистов по BDE стабильно растёт, появляется всё больше проектов, для которых нужен именно инженер больших данных. На hh.ru, по состоянию на начало апреля, имеется 768 вакансий.

-

Пока что конкуренция на позиции Big Data Engineer в разы ниже, чем у Data Scientist. Для специалистов с опытом в разработке сейчас наиболее благоприятное время, чтобы перейти в специальность. Для изучения профессии с нуля или почти с нуля — тоже вполне хорошо (при должном старании). Тенденция роста рынка в целом будет продолжаться ближайшие несколько лет, и всё это время будет дефицит хороших спецов.

-

Задачи довольно разнообразные — рутина здесь есть, но её довольно немного. В большинстве случаев придётся проявлять изобретательность и применять творческий подход. Любителям экспериментировать тут настоящее раздолье.

Минусы

-

Большое многообразие инструментов и фреймворков. Действительно очень большое — и при подготовке к выполнению задачи приходится серьёзно анализировать преимущества и недостатки в каждом конкретном случае. А для этого нужно довольно глубоко знать возможности каждого из них. Да-да, именно каждого, а не одного или нескольких.

Уже сейчас есть целых шесть платформ, которые распространены в большинстве проектов.

Spark — популярный инструмент с богатой экосистемой и либами, для распределенных вычислений, который может использоваться для пакетных и потоковых приложений. Flink — альтернатива Spark с унифицированным подходом к потоковым/пакетным вычислениям, получила широкую известность в сообществе разработчиков данных. Kafka — сейчас уже полноценная потоковая платформа, способная выполнять аналитику в реальном времени и обрабатывать данные с высокой пропускной способностью. ElasticSearch — распределенный поисковый движок, построенный на основе Apache Lucene. PostgreSQL — популярная бд с открытым исходным кодом. Redshift — аналитическое решение для баз/хранилищ данных от AWS.

-

Без бэкграунда в разработке ворваться в BD Engineering сложно. Подобные кейсы есть, но основу профессии составляют спецы с опытом разработки от 1–2 лет. Да и уверенное владение Python или Scala уже на старте — это мастхэв.

-

Работа такого инженера во многом невидима. Его решения лежат в основе работы других специалистов, но при этом не направлены прямо на потребителя. Их потребитель — это Data Scientist и Data Analyst, из-за чего бывает, что инженера недооценивают. А уж изменить реальное и объективное влияние на конечный продукт и вовсе практически невозможно. Но это вполне компенсируется высокой зарплатой.

Data Mining — как собирается и обрабатывается Биг Дата

Загрузка больших данных в традиционную реляционную базу для анализа занимает много времени и денег. По этой причине появились специальные подходы для сбора и анализа информации. Для получения и последующего извлечения информацию объединяют и помещают в “озеро данных”. Оттуда программы искусственного интеллекта, используя сложные алгоритмы, ищут повторяющиеся паттерны.

Хранение и обработка происходит следующими инструментами:

- Apache HADOOP — пакетно-ориентированная система обработки данных. Система хранит и отслеживает информацию на нескольких машинах и масштабируется до нескольких тысяч серверов.

- HPPC — платформа с открытым исходным кодом, разработанная LexisNexis Risk Solutions. HPPC известна как суперкомпьютер Data Analytics (DAS), поддерживающая обработку данных как в пакетном режиме, так и в режиме реального времени. Система использует суперкомпьютеры и кластеры из обычных компьютеров.

- Storm — обрабатывает информацию в реальном времени. Использует Eclipse Public License с открытым исходным кодом.

Это искусственный интеллект?

Скорее, нет — но их не следует ставить далеко друг от друга. Нет — потому что искусственный интеллект, как предполагается — это некий субъект обработки информации. «Мозг», который сам «решает» (а не за него «решают» — пусть и «научили» до этого), что обрабатывать и зачем.

А Big Data – это объект обработки данных, чистая информация. Вместе с тем, во всех случаях, когда ее обрабатывает «интеллект» — качество конечного продукта такой обработки будет определенно выше, чем если бы данные были «простыми» (как вариант — малыми по объему, не обновляемыми и однообразными).

Таким образом, развитие подходов к применению «больших данных» — важнейший фактор развития технологий искусственного интеллекта, машинного обучения, эффективного делегирования различных интеллектуальных функций человека компьютеру. Между Big Data и AI теперь установлена неразрывная связь.

Монетизация процессов: оптимизация текущей деятельности

Автоматизация рутинных операций и оперативный анализ разнородной информации существенно сократит время выполнения, и, соответственно стоимость, многих внутренних бизнес-процессов. В частности, здесь мы рассказывали, как технологии больших данных (Big Data) и машинного обучения (Machine Learning) сэкономили одному американскому банку Goldman Sachs расходы на заработную плату трейдеров в 300 раз, а другому, JPMorganChase, позволили обработать 12 тысяч кредитных договоров за несколько секунд, хотя раньше это занимало около 360 тысяч человеко-часов . Также ранее мы описывали впечатляющие результаты отечественного Сбербанка и других финансовых корпораций по оптимизации банковских бизнес-процессов с помощью Big Data и Machine Learning.

Оптимизация внутренних бизнес процессов сократит расходы и увеличит прибыль

Хотите превратить большие данные своего бизнеса в большие деньги? Приходите к нам на практические курсы, где мы подробно научим вас эффективным методам и средствам сбора, анализа и монетизации данных за счет современных информационных технологий. Специализированные занятия для аналитиков, инженеров и администраторов помогут вам решить прикладные проблемы вашего бизнеса: от снижения оттока клиентов (Churn Rate) до прогнозирования прибыли при запуске нового продукта. Выбирайте свою образовательную программу и до встречи на занятиях!

Источники

- https://www.bigdataschool.ru/bigdata/big-data-соцсети-маркетинг.html

- https://techno.nv.ua/amp/kak-zarabotat-na-big-data-i-drugie-trendy-it-otrasli-blog-igorja-bedy-2139739.html

- https://www.bigdataschool.ru/bigdata/big-data-реклама-и-маркетинг.html

- https://marketelectro.ru/content/marketingovoe-issledovanie-pri-vyhode-na-novyy-rynok-etapy-i-pravila-provedeniya

- http://m.cnews.ru/articles/ekonomika_bolshih_dannyh_sposoby_monetizacii/3

- https://www.bigdataschool.ru/bigdata/machine-learning-и-банки.html

Проблемы с Big-Data

Биг Дата дает нам беспрецедентные идеи и возможности, но также поднимает проблемы и вопросы, которые необходимо решить:

- Конфиденциальность данных – Big-Data, которую мы сегодня генерируем, содержит много информации о нашей личной жизни, на конфиденциальность которой мы имеем полное право. Все чаще и чаще нас просят найти баланс между количеством персональных данных, которые мы раскрываем, и удобством, которое предлагают приложения и услуги, основанные на использовании Биг Даты.

- Защита данных — даже если мы решаем, что нас устраивает то, что у кого-то есть наши данные для определенной цели, можем ли мы доверять ему сохранность и безопасность наших данных?

- Дискриминация данных — когда вся информация будет известна, станет ли приемлемой дискриминация людей на основе данных из их личной жизни? Мы уже используем оценки кредитоспособности, чтобы решить, кто может брать деньги, и страхование тоже в значительной степени зависит от данных. Нам стоит ожидать, что нас будут анализировать и оценивать более подробно, однако следует позаботиться о том, чтобы это не усложняло жизнь тех людей, которые располагают меньшими ресурсами и ограниченным доступом к информации.

Выполнение этих задач является важной составляющей Биг Даты, и их необходимо решать организациям, которые хотят использовать такие данные. Неспособность осуществить это может сделать бизнес уязвимым, причем не только с точки зрения его репутации, но также с юридической и финансовой стороны

Карта пешеходных маршрутов

Магазин типа «Пятёрочки» надо открывать там, где ходят люди. Никто специально не поедет в соседний район ради продуктового магазина, поэтому для начала нужно ответить на такие вопросы:

Где в этом районе ходят люди?

По каким маршрутам?

Сколько их в разное время?

А где точно не ходят?

Чтобы это узнать, можно воспользоваться биг-датой: собрать её или заполучить. Примеры:

У сотового оператора. Можно получить информацию о геопозиции устройств и их примерном перемещении у оператора сотовой связи. Это обезличенные данные без привязки к фамилии или номеру: только информация о пути передвижения устройств в конкретном районе. Это дорого, но эффективно.

Данные собираются с сотовых базовых станций — это устройства, к которым подключаются ваши телефоны, чтобы быть на связи. В городах базовые станции стоят довольно плотно, и по уровню сигнала с них можно довольно точно определить положение всех ближайших абонентов.

Поставить Wi-Fi- и Bluetooth-точки в разных местах нужного района. Они соберут информацию о проходящих мимо людях через их же телефоны. Принцип такой: точка сканирует пространство и ищет мобильники с включённым вайфаем. Как только нашла — начинает его отслеживать до тех пор, пока человек не выйдет из зоны действия. При достаточном количестве таких точек можно получить довольно неплохую карту перемещений.

Поставить камеры с распознаванием лиц. Тут всё относительно просто — располагаем камеры в автомобилях или на зданиях, запоминаем лицо каждого проходящего и путь, по которому он прошёл. Потом накладываем это на карту местности и получаем пешеходные маршруты. Распознавание лиц уже настолько распространённая технология, что это может сделать кто угодно.

После того как мы получили карту перемещений, её нужно проанализировать и найти те точки, где получается максимальная проходимость. В идеале — найти такие места, где пешеходный поток не заходит в магазины конкурентов или где их вообще нет. Для этого просто собираем статистические данные, совмещаем их с картами и используем аналитические приёмы, чтобы сделать выводы.

Rolls-Royce: оптимизация проектирования и производства двигателей

Крупнейший производитель реактивных двигателей для авиакомпаний и военной промышленности с помощью big data создаёт новые продукты и оказывает послепродажную поддержку. При каждом испытании двигателя на стендах генерируются десятки терабайт данных. Изучая их, инженеры могут увидеть недостатки конструкции и дизайна. Аналитика больших данных помогает Rolls-Royce совершенствовать процесс проектирования, сократить время разработки продукта, повысить его качество, а также оптимизировать затраты — чем раньше производитель обнаружит проблему, тем дешевле обходится ее решение.

Что такое большие данные

Большие данные – современное технологическое направление, связанное с обработкой крупных массивов данных, которые постоянно растут. Big Data – это сама информация, методы её обработки и аналитики. Перспективы, которые может принести Big Data интересны бизнесу, маркетингу, науке и государству.

В первую очередь большие данные – это всё-таки информация. Настолько большая, что ей сложно оперировать с помощью обычных программных средств. Она бывает структурированной (обработанной), и неструктурированной (разрозненной). Вот некоторые её примеры:

• Данные с сейсмологических станций по всей Земле.

• База пользовательских аккаунтов Facebook.

• Геолокационная информация всех фотографий, выложенных за сегодня в Instagram.

• Базы данных операторов мобильной связи.

Для Big Data разрабатываются свои алгоритмы, программные инструменты и даже машины. Чтобы придумать средство обработки, постоянно растущей информации, необходимо создавать новые, инновационные решения. Именно поэтому большие данные стали отдельным направлением в технологической сфере.

Немного про Cloud-Native подход в Data Science

Cloud-Native подход работы с большими данными отличается от традиционного тем, что:

- Позволяет разделить Storage- и Compute-слои. В Hadoop каждая нода является и Storage-, и Compute-слоем. Для наращивания объема HDFS необходимо добавлять в кластер новые ноды, а значит и процессорные ядра, которые, возможно, вам не нужны. Кроме того, такие системы, как Hadoop, Arenadata DB или ClickHouse, относительно тяжело масштабируются: сложно оперативно добавлять и убирать узлы. А в Cloud Native подходе для хранения данных используется распределенное отказоустойчивое S3-хранилище, которое дешевле HDFS. Вынося ноды в S3, мы разделяем Storage- и Compute-слои, а значит, решаем проблему независимого увеличения объема хранения. Кроме того, вынося данные в S3, мы задействуем хранилище как сервис: не нужно думать о сайзинге нод, hardware, следить за емкостью кластера, думать о том когда его пора масштабировать.

- Позволяет получить преимущества вроде автомасштабирования мощностей, изоляции сред и интеграции инструментов. Это возможно благодаря тому, что часть инструментов мы запускаем в Kubernetes.

Подробнее посмотрим на примере конкретных инструментов:

- Spark — для обработки данных,

- Presto и Hive Metastore — для доступа к данным,

- Superset — для построения дашбордов,

- Airflow — для управления рабочими процессами,

- Amundsen — для Data Discovery,

- JupyterHub — для тренировки моделей и экспериментов в Data Science,

- Kubeflow — для построения MLOps в Kubernetes.

Использование Биг Дата — это законно?

По крайней мере, в России — обещает быть «законным» вполне официально. Минкомсвязи РФ не так давно опубликовало законопроект, в котором дается определение больших данных и регламентируется их обработка. Это будет происходить под внимательным присмотром Роскомнадзора. В законопроекте дается довольно сложное определение «большим данным», в основе которого — отнесение таких данных к неперсонифицированным.

Есть проекты различных частных регулирующих нормативов — «кодексов саморегулируемости» и иных, на основании которых субъекты, участвующие в обработке больших данных, могут организовывать свою работу.

Но совершенно очевидно, что в силу сложности и неопределенности состава «больших данных» крайне проблематично издать универсальные нормы, которым бы все обязаны были следовать при их обработке. Как мы уже отметили выше, «большие данные» — это чистая практика, соответственно, нормы, если и должны появляться, то не в качестве причины возникновения тех или иных механизмов обработки Big Data, а как следствие внедрения таких механизмов.

Соответственно, основным назначением таких норм должно быть не «упорядочивание ради упорядочивания» — а улучшение механизмов. Возможно — придание им большей применимости на практике в тех или иных сферах.

Актуальность и перспективы

Big Data вызывает немало вопросов. Эта область сегодня развивается весьма стремительно, но люди задумываются – а стоит ли вообще углубляться в соответствующую сферу деятельности. Ведь для того, чтобы добиться успеха в качестве аналитика «больших данных», придется изучить и усвоить немало информации.

Ответ однозначен – да. В России, Америке и других развитых странах вместе с «большими сведениями» с 2015 года началось развитие так называемого «блокчейна». Это – отличное дополнение изученного термина, обеспечивающее защиту и конфиденциальность электронных материалов.

Статистика показывает – инвестициями в Big Data занимаются почти все существующие крупные и известные корпорации. Кто-то — больше, кто-то – меньше. Анализ соответствующих данных помогает обнаруживать различные скрытые схемы. Они потребуются при разработке наиболее эффективных и инновационных технологий и бизнес-проектов. А если учесть не только то, какие определение имеет Big Data, но и перспективы развития IT, можно сделать вывод – большие данные со временем окажутся еще более ценными.

Язык данных — для решения проблем мирового масштаба

Сегодня навыки работы с данными становятся новым универсальным языком для исследователей. За примером далеко ходить не надо. Так, в борьбе с COVID-19 ученые со всего мира объединили усилия в поиске лекарств и разработке вакцин, а также анализе научных публикаций, прогнозировании распространения эпидемии, предсказании по результатам КТ и характеру кашля вероятности заражения коронавирусом.

Индустрия 4.0

Большие данные против коронавируса: 24 модели окончания пандемии

Это доказывает, что человечество обладает необходимыми средствами для того, чтобы дать отпор неожиданно появившемуся противнику, и способно разговаривать на одном языке — языке данных.

История возникновения

Работы с большими данными ведутся на постоянной основе. И объем получаемой информации возрастает в геометрической прогрессии. То, что несколько десятилетий назад казалось объемным, сейчас – мизер.

Впервые большие «даты» возникли в 70-х годах прошлого столетия. Тогда образовались центры обработки информации. К 2005 году по мере роста технологического прогресса фирмы стали разбираться в масштабах контента пользователями интернет сервисов (YouTube, VK, Facebook и так далее).

В этот же момент создали первую платформу, которая по мере роста количества поступаемых материалов научилась работать с большими объемами. Ее название – Hadoop. Ныне это – стек технологий для обработки информации. Далее популярность набрал некий NoSQL. Представляет собой некую совокупность методов для создания систем управления BigData.

Лучшие книги по Big Data

«The Human Face of Big Data», Рик Смолан и Дженнифер Эрвитт

Подойдет для первоначального изучения технологий обработки больших данных – легко и понятно вводит в курс дела. Дает понять, как обилие информации повлияло на повседневную жизнь и все ее сферы: науку, бизнес, медицину и т. д. Содержит многочисленные иллюстрации, поэтому воспринимается без особых усилий.

«Introduction to Data Mining», Панг-Нинг Тан, Майкл Стейнбах и Випин Кумар

Также полезная для новичков книга по Big Data, объясняющая работу с большими данными по принципу «от простого к сложному». Освещает многие немаловажные на начальном этапе моменты: подготовку к обработке, визуализацию, OLAP, а также некоторые методы анализа и классификации данных.

«Python Machine Learning», Себастьян Рашка

Практическое руководство по использованию больших данных и работе с ними с применением языка программирования Python. Подходит как студентам инженерных специальностей, так и специалистам, которые хотят углубить свои знания.

«Hadoop for Dummies», Дирк Дерус, Пол С. Зикопулос, Роман Б. Мельник

Hadoop – это проект, созданный специально для работы с распределенными программами, организующими выполнение действий на тысячах узлов одновременно. Знакомство с ним поможет более детально разобраться в практическом применении больших данных.

Рынок технологий больших данных в России и мире

По данным на 2014 год 40% объема рынка больших данных составляют сервисные услуги. Немного уступает (38%) данному показателю выручка от использования Big Data в компьютерном оборудовании. Оставшиеся 22% приходятся на долю программного обеспечения.

Наиболее полезные в мировом сегменте продукты для решения проблем Big Data, согласно статистическим данным, – аналитические платформы In-memory и NoSQL . 15 и 12 процентов рынка соответственно занимают аналитическое ПО Log-file и платформы Columnar. А вот Hadoop/MapReduce на практике справляются с проблемами больших данных не слишком эффективно.

Результаты внедрения технологий больших данных:

- рост качества клиентского сервиса;

- оптимизация интеграции в цепи поставок;

- оптимизация планирования организации;

- ускорение взаимодействия с клиентами;

- повышение эффективности обработки запросов клиентов;

- снижение затрат на сервис;

- оптимизация обработки клиентских заявок.

Определение

Биг Дата или большие данные – это целые комплексы информации, собранные в «пачки». Они просто огромных размеров. Если дать обычному компьютеру соответствующие сведения, он не справится с поставленными задачами. Обработка завершится неудачей.

Большие данные собираются различного формата, относятся к неструктурированным и могут содержать те или иные ошибки. Накапливаются очень быстро. Задействуются для совершенно разных целей.

Big Data – вовсе не обычная база данных. Чтобы понять этот факт, требуется дать изучить несколько примеров. Сначала указываются небольшие сведения, после – большие (через «/»):

- Записи о работниках компании. Здесь материалы и свойства заранее предопределены. Возможно формирование Excel-таблицы./Журнал сведений о действиях работников предприятия. Дать четкую характеристику не получится. Собираются материалы непосредственно во время выполнения должностных обязанностей.

- Все личные данные юзеров в Facebook./Тапы по экрану во время работы с Фейсбуком, а также отправленные и получаемые сообщения, репосты и лайки.

- Архив записей с камер наблюдения (типа «Безопасный город»)./Видеофиксация нарушений ПДД. Здесь тоже дать конкретику заранее не представляется возможным.

Для работы с большими данными приглашают специально обученных людей. Но об этом будет рассказано позже. В первую очередь требуется изучить, какие особенности и нюансы имеют большие объемы информации.

Резюме

Big Data – это некая статистика (по замыслу Минкомсвязи — «неперсонифицированная», но, понятно, что она может быть разной по сути), на основании которой можно сделать некие прогнозы. По росту цен, по поведению клиентов — что угодно. Собираемость такой статистики стала возможна благодаря распространению технологий для ее сбора (гаджеты, онлайн-кассы и прочее), а также технологий для ее обработки: выросли вычислительные мощности, выросла пропускная способность интернета для обмена данными.

Видео — Игорь Ашманов о сборе «больших данных»и об аналитике Big Data:

Что такое «большие данные»

Вопрос «что называть большими данными» довольно путаный. Даже в публикациях научных журналов описания расходятся. Где-то миллионы наблюдений считаются «обычными» данными, а где-то большими называют уже сотни тысяч, потому что у каждого из наблюдений есть тысяча признаков. Поэтому данные решили условно разбить на три части — малые, средние и большие — по самому простому принципу: объему, который они занимают.

Малые данные — это считанные гигабайты. Средние — все, что около терабайта. Одна из основных характеристик больших данных — вес, который составляет примерно петабайт. Но путаницу это не убрало. Поэтому вот критерий еще проще: все, что не помещается на одном сервере — большие данные.

В малых, средних и больших данных разные принципы работы. Большие данные как правило хранятся в кластере сразу на нескольких серверах. Из-за этого даже простые действия выполняются сложнее.

Например, простая задача — найти среднее значение величины. Если это малые данные, мы просто все складываем и делим на количество. А в больших данных мы не можем собрать сразу всю информацию со всех серверов. Это сложно. Зачастую надо не данные тянуть к себе, а отправлять отдельную программу на каждый сервер. После работы этих программ образуются промежуточные результаты, и среднее значение определяется по ним.

Сергей Ширкин

Готовые сервисы на основе big data

На технологиях анализа больших данных построены привычные нам антиспам, антифрод, programmatic-реклама и товарные рекомендации. Для использования готовых сервисов не нужны ни дополнительные сервера, ни консультанты, ни data scientists. Данные эти системы берут из открытых источников — соцсетей, сайтов, форумов и СМИ. Это открывает клиентам широкие возможности для цифрового маркетинга без затрат на инфраструктуру.Большие данные занимают центральное место в экосистеме RTB-рекламы. Платформы управления данными (DMP) собирают информацию о пользователях в виде сегментов аудитории, биржи данных (data exchange) — в виде обезличенных профилей. Эти данные обеспечивают максимально точное таргетирование RTB-рекламы, минимизируя затраты рекламодателя и раздражение потенциального покупателя. Такие услуги предлагают отечественные компании Auditorius, Data-Centric Alliance, RTB Media, RuTarget/Segmento, Between Digital, Hubrus DSP, Adfox, AdRiver, GetIntent, Kavanga и другие.Большими данными из открытых источников оперируют также многочисленные сервисы товарных рекомендаций (Retail Rocket, Crosss, REES46, «1С-Битрикс Big Data»), персонализации контента (Flocktory, Usalytics) и целевого маркетинга (Opiner, SmartBox eCRM, Witget). На этом основании все они тоже являются частью российского рынка больших данных.О некоторых стартапах, работающих с big data в России, мы подробно рассказали здесь: Кто делает big data в России?Старейшие отечественные IT-холдинги анализируют большие данные собственными силами. Так они совершенствуют собственные сервисы, таргетируют рекламу и персонализируют контент.Mail.Ru GroupЗадолго до появления термина big data холдинг вовсю использовал технологии обработки больших данных. Первым таким проектом была система веб-аналитики «Рейтинг Mail.Ru». Сейчас анализ больших данных задействован практически во всех продуктах компании — «Таргет.Mail.Ru», «Почта Mail.Ru», «Одноклассники», «Мой Мир», «Поиск Mail.Ru» и других. С помощью обработки big data Mail.Ru фильтрует спам, таргетирует рекламу, оптимизирует поиск, ускоряет работу техподдержки, анализирует поведение пользователей, предлагает им контакты и подписки. Для офлайновой обработки данных компания использует платформу Hadoop, для онлайна — собственную разработку NoSQL СУБД Tarantool.«Рамблер»Изначально медиахолдинг работал с большими данными в части поиска. В последние пару лет компания активизировала направление датамайнинга. Технологии big data «Рамблер» применяет для таргетинга рекламы, персонализации контента, блокировки спама и ботов, обработке естественного языка. Технологическая сторона этой работы — платформы для обработки больших данных Hadoop/Spark/Mahout и Python Scipy/Scikit-learn. В дальнейшем компания собирается оттачивать рекламные технологии и персонализацию контента.Также «Рамблер» ставит на развитие сервисов контентной аналитики для PR. В июле он купил 51% компании RCO, которая выпускает приложения для интеллектуальной обработки текстов на разных языках. Продуктами RCO пользуются «Газпром», Минюст, Центробанк, ФСБ, «Роснано», «МегаФон», «Сбербанк» и другие организации.

Какие тренды обсуждает сообщество

Постепенно набирает силу еще одно направление, которое может привести к бурному росту количества данных — Интернет вещей (IoT). Большие данные такого рода поступают с датчиков устройств, объединенных в сеть, причем количество датчиков в начале следующего десятилетия должно достигнуть десятков миллиардов.

Устройства самые разные — от бытовых приборов до транспортных средств и промышленных станков, непрерывный поток информации от которых потребует дополнительной инфраструктуры и большого числа высококвалифицированных специалистов. Это означает, что в ближайшее время возникнет острый дефицит дата инженеров и аналитиков больших данных.

Освоить востребованную профессию в Аналитике больших данных можно всего за полтора года на курсах GeekBrains.

О методах работы

При помощи искусственного интеллекта и других высокотехнологичных устройств происходит обработка информации большего размера, нежели при задействовании «обычных гаджетов». Пример – нейро сети.

Всего существуют следующие методы работы с большими «датами»:

- анализы социальных сетей (отдельно – настроений, правил обучения, дерева классификации);

- машинное обучение;

- генетические алгоритмы;

- регрессионный анализ.

Это – основные варианты развития событий. Далее каждый из них будет рассмотрен более подробно. Тогда за один раз пользователь сможет точно понять, с чем ему предстоит иметь дело.

Машинное обучение

Оно помогает при:

- обнаружении спама и рекламы;

- сборе Big Data относительно пользовательских предпочтений и создании рекомендаций;

- поиске наилучшего контента для того, чтобы привлекать и удерживать новых клиентов (та же контекстная реклама);

- установке юртарифов;

- определении вероятности того, насколько конкретное дело является выигрышным/выгодным.

Пример – человек в интернете просматривает новости или ищет информацию в Google. Алгоритм изучает соответствующие сведения и предлагает нечто схожее. Искусственные интеллекты без явных признаков программирования способны создавать прогнозы путем уже известных свойств. Последние извлекаются из «обучающих данных».

Анализ соцсетей и настроений

В случае с настроением метод задействован для:

В случае с социальными сетями анализ используется, чтобы:

прояснить принципы формирования связей между людьми из разных слоев населения;

уточнить важность конкретной личности в обществе;

отыскать минимальные связи для соединения двух человек;

понять структуру социального типа клиентской базы.

Последний вариант особо полезен при телекоммуникациях.

Правила ассоциации

Этот подход необходим для:

- размещения продуктов так, чтобы увеличивались их продажи;

- извлечения данных о посетителях веб-страничек;

- анализа биоданных;

- отслеживания системных журналов, чтобы вовремя определять потенциальных злоумышленников;

- определения, стали ли покупатели одного товара покупать другую продукцию чаще.

Использует соответствующих подход обычно каждая торговая точка. Задействуются материалы, получаемые посредством POS-систем.

Дерево классификаций

Этот метод применяется при:

- автоматическом присваивании документов тем или иным категориям;

- классификации по различным группам тех или иных организмов;

- разработке Личный Кабинетов для учащихся в режиме онлайн.

При помощи статистической классификации в Big Data производится определение категорий, к которым можно отнести новое наблюдение.

Генетический алгоритм

Применяется при:

- составлении расписаний;

- расчете оптимального сырья для производства;

- создании «искусственно творческого» контента – игры слов, шуток, анекдотов.

Вдохновляются принципами работы эволюции. Сконцентрированы на наследовании, естественном отборе и мутации.

Регрессия

Регрессионный анализ используется для решения следующих задач:

- определение степени удовлетворенности посетителей;

- изучение принципов воздействия погоды на частоту звонков в службы поддержки;

- определение влияния на стоимость жилья его района и размеров.

Предусматривает прием манипулирование независимыми переменными. Это делается для того, чтобы просмотреть принципы влияния на зависимые сведения.

Решения на основе Big data: «Сбербанк», «Билайн» и другие компании

У «Билайна» есть огромное количество данных об абонентах, которые они используют не только для работы с ними, но и для создания аналитических продуктов, вроде внешнего консалтинга или IPTV-аналитики. «Билайн» сегментировали базу и защитили клиентов от денежных махинаций и вирусов, использовав для хранения HDFS и Apache Spark, а для обработки данных — Rapidminer и Python.

Или вспомним «Сбербанк» с их старым кейсом под названием АС САФИ. Это система, которая анализирует фотографии для идентификации клиентов банка и предотвращает мошенничество. Система была внедрена ещё в 2014 году, в основе системы — сравнение фотографий из базы, которые попадают туда с веб-камер на стойках благодаря компьютерному зрению. Основа системы — биометрическая платформа. Благодаря этому, случаи мошенничества уменьшились в 10 раз.

Эволюция профессии: от 1960-х годов до наших дней

Кого-то это может удивить, но анализ данных — совсем не новое направление. Первые специалисты в этой области появились еще в середине 1960-х годов, когда начали зарождаться методы извлечения полезной информации из данных. Современные специалисты отличаются от этих первопроходцев большим набором доступных инструментов для работы — компьютеров, фреймворков (начиная с Excel и заканчивая профессиональным ПО вроде Sklearn, RapidMiner, TensorFlow и прочими), и неограниченным доступом в интернет. А еще — более сложными и интересными задачами, которые появились благодаря развитию технологий.

Если раньше данные анализировали в основном для того, чтобы мониторить процессы, то теперь есть возможность строить предиктивные модели, предсказывать последствия тех или иных шагов или изменений рыночной ситуации и своевременно реагировать на нее.

Футурология

Предикативная аналитика: как предсказать эпидемию и успех в бизнесе

Вывод

Если у вас нет DWH, то простой MVP можно накликать в облаке. Вы выбираете продукт, который поддерживается managed-сервисом, тот же Hadoop, и у вас уже есть какое-то хранилище. Попробуйте, и вы поймете, что это лучше, чем без хранилища.

Если вас не устраивает ваше DWH, попробуйте посмотреть на технологии вокруг. Для нас это был стресс. Я помню, каким для меня было вызовом, когда мне сказали: «Твой бесплатный Hadoop работает плохо, давайте посмотрим, какие есть платные хорошие решения». Я в ответ: «Что? Мой Hadoop? Да я сейчас напишу на Spark, всё будет работать очень быстро». Но я благодарен своим руководителям за то, что они предложили погонять PoC, и я понял, что коробочные решения могут делать гораздо быстрее и надежнее, чем Hadoop, который нужно настраивать несколько месяцев под одну задачу. Смотрите вокруг, ищите что-то хорошее, читайте Хабр и Medium. Иногда даже специфические продукты взлетают.